Celui-ci prévoit donc d'améliorer l'anticipation des risques climatiques. D'une part, il clarifie les hypothèses avec la Trajectoire de Référence pour l'Adaptation au Changement Climatique (TRACC), le fameux "scénario +4°C" qui doit désormais servir de référence commune. D'autres part, il impose d'évaluer l'impact du changement climatique sur de nombreuses entreprises et activité, notamment dans les infrastructures, les transports et l'énergie.

Transports : tous les modes et opérateur concernés à court-terme

Dans le secteur des transports, l'objectif est de réaliser des études de vulnérabilité pour l’ensemble des réseaux et des grandes infrastructures - SNCF Réseau, SNCF Gares & Connexion, SNCF Voyageurs, RATP, les

grands ports maritimes, les principaux aéroports, le réseau routier... Ceux qui ont déjà fait ce type d'étude devront se mettre en conformité avec la TRACC.

Côté réseau ferré, SNCF Réseau a adopté en février 2024 une stratégie d’adaptation au changement climatique comportant une feuille de route 2024-2026, établie sur la base des analyses de vulnérabilité et des travaux d’ingénierie. Une étude globale de la vulnérabilité est en cours de mise à jour avec la TRACC, des études locales sont en cours ou prévues. Pour les nouveaux projets, un examen de la démarche d’adaptation sera mis en place lors de l’approbation par le Comité National des Investissements et des Engagements.

Une analyse de vulnérabilité sur 3000 gares a été effectuée en 2024 par SNCF Gares et Connexions. La feuille de route 2025-2030 prévoit de "continuer à investir dans la connaissance des impacts climatiques actuels et futurs sur les gares".

Pour les réseau urbains et régionaux, RATP a réalisé une étude de vulnérabilité "à dire d’experts" qui doit être mise à jour pour intégrer les données TRACC. La Société des Grands Projets (le maitre d'ouvrage du Grand Paris) va demander systématiquement la réalisation d’études de vulnérabilité au changement climatique dans le cadre des nouveaux appels d’offres à partir de 2025.

Enfin les projets de services express régionaux métropolitains devront intégrer une évaluation de la vulnérabilité.

Côté aéroports, les exploitants d’Aéroports de Paris, Aéroports de la Côte d’Azur, Lyon Saint-Exupéry, Bordeaux-Mérignac, la Réunion Roland Garros, Guadeloupe-Maryse Condé, Martinique Aimé Césaire, Strasbourg-Entzheim, Montpellier-Méditerranée, Marseille-Provence et Toulouse-Blagnac doivent réaliser en 2025 "une étude de vulnérabilité au changement climatique selon la TRACC et une ébauche de plan d’actions chiffré intégrant une première estimation des coûts à engager".

Et pour les ports, Bordeaux, La Rochelle,

Guadeloupe, La Réunion et La Martinique ont déjà réalisé des études qui devront être actualisée avec la TRACC. Des études sont en cours pour Nantes-Saint-Nazaire, Dunkerque et Guyane et prévues pour les autres Grands Ports Maritimes (Haropa, Marseille).

Une étude est également en cours pour évaluer la vulnérabilité du réseau routier national, y compris les autoroutes concédées.

Énergie : assurer la résilience des systèmes et réseaux

Dans l'énergie, la priorité est d'améliorer la résilience du système électrique, y compris des production éolienne et solaire et du réseau.

RTE va réaliser une mise à jour des Futurs énergétiques 2050 en 2026 avec une nouvelle évaluation de l'impact du changement climatique sur le système électrique en cohérence avec la TRACC. Cette évaluation devra également adopter "une approche multi-modèles" (c'était une des limitation de l'étude précédente qui n'utilisez qu'un seul modèle). L'actualisation portera aussi sur :

- l’exposition au changement climatique de l’ensemble des filières, et en particulier les filières de d’énergie éolienne et photovoltaïque, à partir de scénarios climatiques, y compris "les conséquences de scénarios à faible probabilité".

- la disponibilité de la ressource en eau et ses conséquences pour la production électrique, en prenant en compte les résultats de l'étude Explore 2.

RTE devra aussi réaliser très prochainement des stress test pour valider la résilience du réseau dans des situation extrêmes, par exemple canicule combinée à une période sans vent.

Pour le réseau de distribution, Enedis va poursuivre l'enfouissement des réseaux dans les zones à risque d'incendie et le remplacement des éléments identifiés comme ayant un risque de défaillance. L'objectif est de renouveler d’ici 2040 la majorité des ouvrages les plus sensibles au risque de vagues de chaleur, ce qui nécessite des études préalables afin de prioriser les tronçons à renouveler en fonction de leur risque d’incidents, de l’exposition au risque de canicule et de leur impact client.

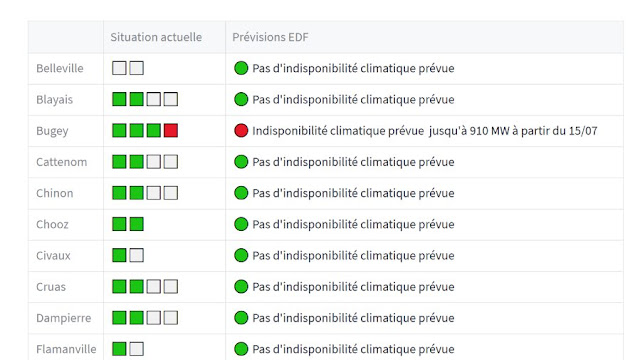

Des travaux sont également prévus du côté d'EDF (notamment sur le nucléaire) et des exploitant hydroélectrique.

Dans l'industrie pétrolière et gazière, l'évaluation des vulnérabilités portera principalement sur l’approvisionnement et la logistique. Trois études sont prévues pour 2026 sur les installations de transit international, la logistique pétrolière nationale et la navigabilité des fleuves, en particulier du Rhin.

Opérateurs d'importance vitale et installation Seveso

Le projet de PNACC mis en consultation à l'automne prévoyait aussi des études de vulnérabilité climatique pour les opérateurs d’importance vitale (OIV), c'est-à-dire 1400 sites "vitaux à la survie de la nation" (industries d'armement, traitement de l'eau, services financiers, installations sanitaires majeures...). La version définitive se contente d'annoncer la transposition dans le droit français de la directive 2022/2557 sur la résilience des entités critiques. Celle-ci prévoit notamment que "les États membres veillent à ce que les entités critiques prennent des mesures […] pour prévenir la survenance d’incidents, en tenant dûment compte de mesures de réduction des risques de catastrophe et d’adaptation au changement climatique."

Dans le vague également, les nouvelles exigences sur les études de danger des installation Seveso ou des installations classées pour la protection de l'environnement (ICPE). Les aléas devraont être mis en cohérence avec la TRACC mais la méthodologie reste à définir.

Établissements scolaires et sanitaires

Il n'y a pas que l'industrie et les infrastructures dans la vie... le PNACC prévoit aussi de recenser les établissements scolaires "particulièrement menacés par le recul du trait de côte, la montée des eaux, les inondations ou d’autres risques climatiques extrêmes".

Une étude prospective sur les conséquences du changement climatique sur le système de santé va être lancée. Elle devra aider à anticiper les besoin de formation (reconnaitre et traiter les maladies liées au changement climatique), de ressources humaines (augmentation des besoins dans certaines spécialités) et l'impact sur la chaine d’approvisionnement (produits de santé, énergie, eau…).

Un inventaire complet du parc immobilier des établissements de santé et établissements sanitaires, sociaux et médico-sociaux est également prévu afin d'analyser son exposition au risques climatiques : confort thermique, risque d’inondation, alimentation en eau potable, risques sanitaires, dommage au bâtiment, alimentation en eau et en énergie... L’objectif est d'identifier et de prioriser les établissements devant faire l’objet d’une étude de vulnérabilité plus poussée.